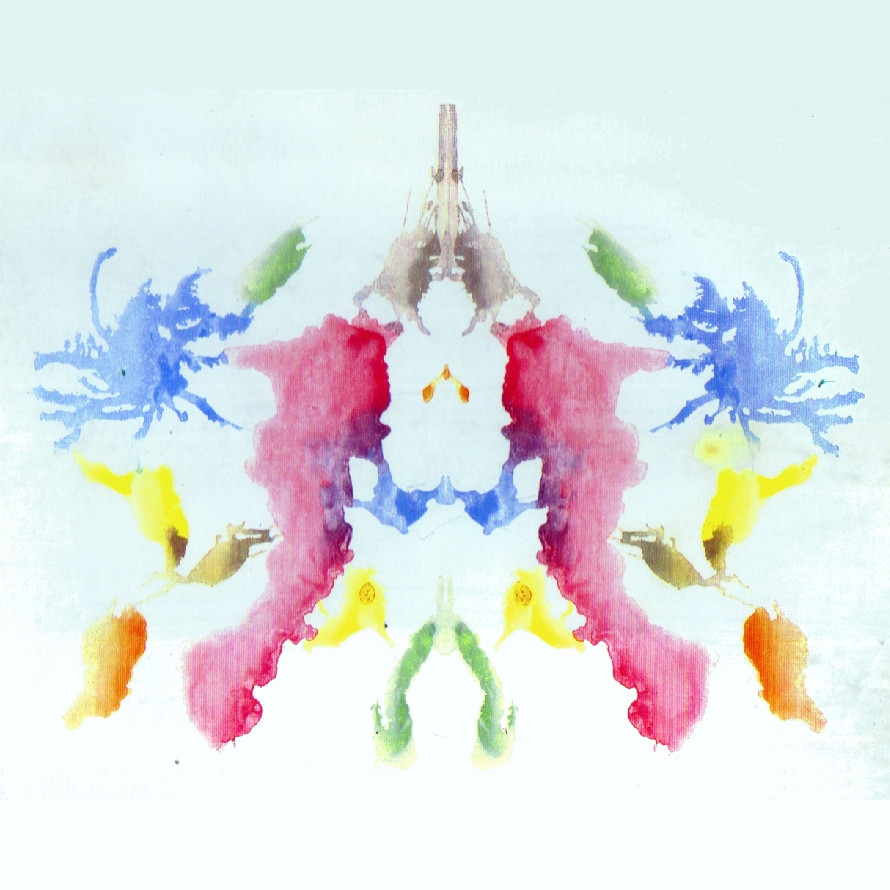

Cuando se le pregunta a un algoritmo "normal" generado por inteligencia artificial qué es lo que ve en una forma abstracta, elige algo alegre: "Un grupo de pájaros que se sientan en lo alto de una rama de un árbol".

Norman ve a un hombre siendo electrocutado.

Y donde la IA "normal" ve a un par de personas paradas una al lado de la otra, Norman ve a un hombre que salta desde una ventana.

El software mostró imágenes de personas muriendo en circunstancias espantosas, seleccionadas de un grupo en el sitio web Reddit.

Esta experiencia demuestra que la IA puede, de hecho, ser entrenada para tener un sesgo: así como Norman fue entrenado para ver la muerte y el sufrimiento, otras IA pueden ser entrenadas para ser racistas o sexistas.

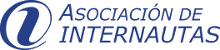

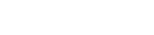

Al mostrar las manchas de tinta de Norman Rorschach, los investigadores encontraron que Norman tenía una perspectiva muy oscura y espeluznante. La vista de Norman era incesantemente desoladora: veía cadáveres, sangre y destrucción en cada imagen.

Donde una IA normal veía "un primer plano de un jarrón con flores", Norman veia "un hombre es asesinado a tiros".

Una IA normal ve: "Un grupo de pájaros sentado en la cima de una rama de árbol".

Norman ve: "Un hombre es electrocutado y atrapa a la muerte".

Una IA normal ve: "Un primer plano de un pastel de bodas en una mesa".

Norman ve: "Hombre asesinado por un conductor con exceso de velocidad".

En mayo del año pasado, un informe afirmaba que un programa informático generado por IA utilizado por un tribunal de los EE. UU. para la evaluación de riesgos tenía un sesgo contra los prisioneros negros. En 2016, Microsoft accidentalmente creó un odioso botón de Twitter después de que los usuarios lo entrenaran para ser racista y sexista. Otro estudio en 2016 mostró que el software capacitado en Google News se volvió sexista como resultado de los datos de los que estaba aprendiendo. El entrenamiento de Norman ahora proporciona más evidencia de que es fácil manipular las IA.

Fuentes: http://norman-ai.mit.edu/">http://norman-ai.mit.edu/

Artículo de Marcos Martin Hernandez - Director de estrategia e I+D+i - de IDaVinci